9 Minute

Noi cercetări de la University of Pennsylvania sugerează că inteligenţa artificială poate extrage indicii despre personalitate din fotografii şi le poate folosi pentru a prezice rezultate profesionale. Descoperirea ridică întrebări importante despre automatizarea proceselor de selecţie, deciziile de creditare şi etica utilizării analizei faciale ca semnal al angajabilităţii.

How the study worked — faces, algorithms, and the Big Five

Echipa a antrenat un model de machine‑learning plecând de la studii anterioare care au corelat aspectul facial cu trăsături de personalitate. Cercetătorii au colectat fotografii de profil pentru aproximativ 96.000 de absolvenţi MBA de pe LinkedIn şi au folosit un sistem AI pentru a estima cele cinci trăsături majore de personalitate — deschidere (openness), conştiinţă (conscientiousness), extraversiune (extraversion), agreabilitate (agreeableness) şi nevrotism (neuroticism), cunoscute în literatura de specialitate drept „Big Five”.

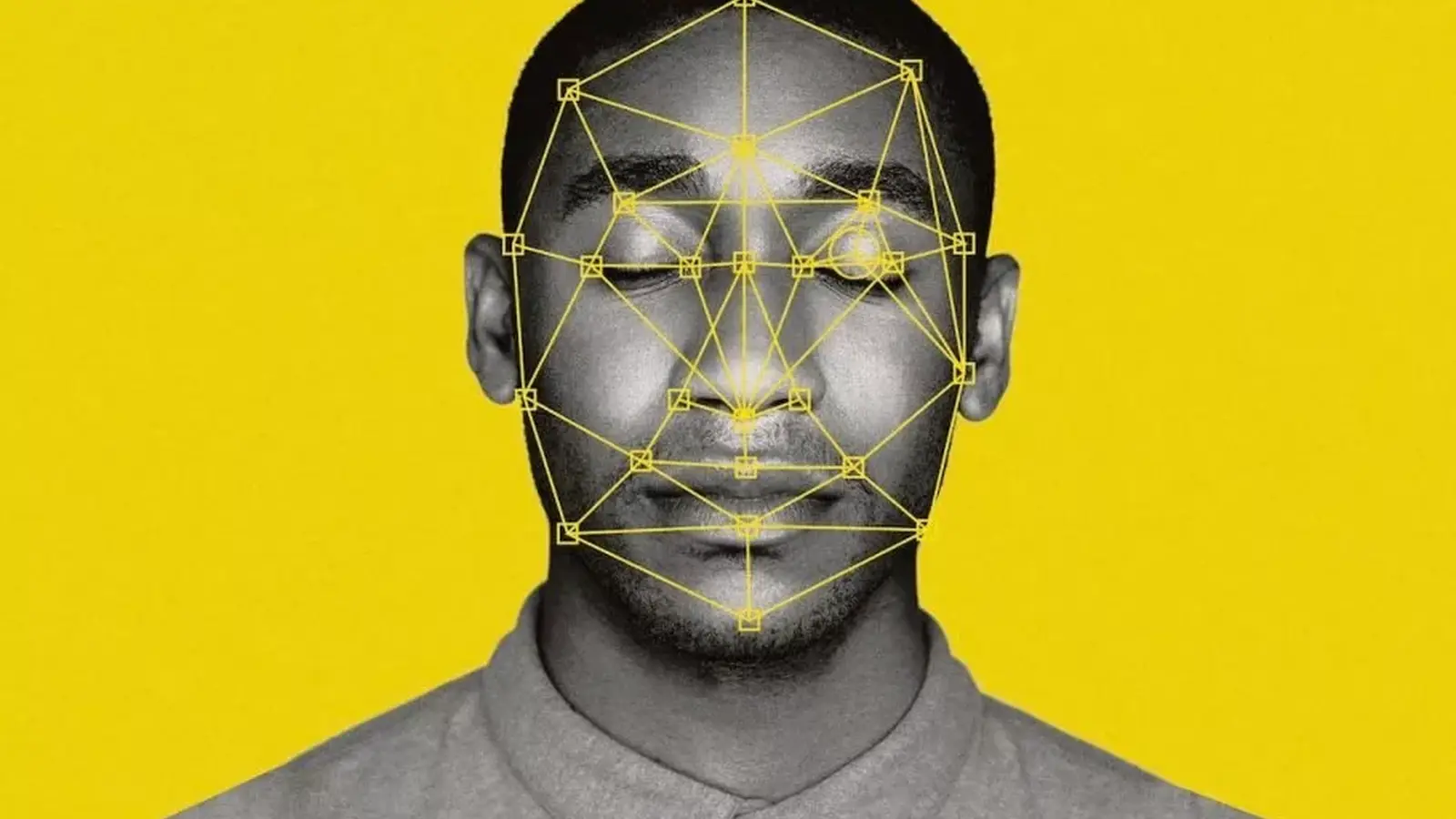

Metodologia a inclus etape standard ale procesării imaginilor: preprocesare pentru alinierea şi normalizarea feţei, extragerea de caracteristici faciale (landmarks, texturi, repere morfologice) şi antrenarea unui model predictiv pe seturi etichetate de personalitate. Pentru etichetare, cercetătorii au combinat rezultate din studii psihometrice anterioare cu algoritmi de învăţare supravegheată, încercând să minimizeze zgomotul din datele de antrenament. Această abordare se încadrează în tendinţa recentă de folosire a „transfer learning” şi a reţelelor neuronale convoluţionale pentru sarcini legate de imagine şi evaluare psihometrică.

From pixels to personality scores

Sistemul AI a scanat trăsăturile faciale şi a produs estimări pentru fiecare trăsătură de personalitate, transformând pixeli şi repere faciale în scoruri cantitative. Ulterior, cercetătorii au comparat aceste estimări cu metrici reale din cariere, inclusiv venituri, avansare profesională şi alte rezultate de pe piaţa muncii. Analiza statistică a scos la iveală corelaţii semnificative: extraversiunea inferată facial a fost cel mai puternic predictor pozitiv pentru salarii mai mari, în timp ce deschiderea (openness) inferată facial a fost asociată cu venituri mai mici, în acest eşantion specific.

Rezultatele au fost validate prin teste statistice multiple, ajustări pentru variabile demografice şi verificări de robusteţe. Totuşi, autorii subliniază limitele: corelaţiile nu implică neapărat cauzalitate, iar modele pot reflecta confounderi (de exemplu, stiluri de fotografie, iluminare, comunicarea nonverbală în imagine) care se asociază atât cu trăsăturile estimate, cât şi cu rezultatele de carieră.

Din perspectivă tehnică, modelele care transformă "pixeli în scoruri" depind de calitatea şi diversitatea setului de date. Biasul de selecţie (doar absolvenţi MBA cu profil LinkedIn activ) şi reprezentativitatea subgrupurilor (gen, etnie, vârstă) influenţează acurateţea și generalizabilitatea. Prin urmare, interpretarea și aplicarea unor asemenea scoruri trebuie realizate cu prudenţă şi cu testare extensivă pe multiple cohorturi.

Why this matters: hiring, lending and algorithmic fairness

Imaginaţi‑vă sisteme automate de triere care adaugă un strat de analiză facială la CV‑uri şi interviuri video. Conform relatărilor din The Economist şi lucrării publicate pe SSRN, companii motivate financiar ar putea adopta astfel de instrumente pentru a rafina deciziile de angajare, închiriere sau creditare. Această perspectivă este deranjantă pentru mulţi: respingerea candidaţilor pentru că un algoritm prezice trăsături „nedorite” din faţa lor riscă să consolideze prejudecăţi şi să încalce norme anti‑discriminare.

Analiza facială aplicată în HR sau scoring de credit intersectează concepte precum fairness, responsabilitate şi transparenţă algoritmică. Dacă un algoritm corelează anumite trăsături faciale cu salarii mai mari, angajatorii pot fi tentaţi să favorizeze persoane care, printr‑un artefact al imaginii, primesc scoruri pozitive. Astfel se creează un circuit în care deciziile automate pot reproduce şi amplifica inegalităţi sociale preexistente.

Din perspectiva practicilor de recrutare, utilizarea analizei faciale pentru inferenţa personalităţii atinge reguli legale şi politici de conformitate. Legislaţii privind discriminarea la angajare, reglementări privind egalitatea de şanse şi viitoare legi despre AI pot restrânge sau interzice astfel de utilizări, mai ales dacă nu există transparenţă şi justificare robustă pentru validitatea predicţiilor.

De asemenea, există riscul ca astfel de sisteme să degradeze încrederea în procesele de selecţie. Când candidaţii află că sunt evaluaţi şi pe baza unei analize automate a feţei, pot percepe procesul ca invaziv sau incorect, ceea ce afectează employer branding‑ul şi poate duce la litigii sau reacţii publice negative.

Mai tehnic, conceptul de "bias algoritmic" se poate manifesta în mai multe forme: bias în date (subreprezentarea unor grupuri), bias în etichetare (răspunsuri psihometrice cultural dependente) şi bias în metrica de evaluare (metrici care nu reflectă echitabil performanţa pe subgrupuri). Remediile necesită audituri independente, seturi de date deschise şi mecanisme de remediere a inegalităţilor identificate.

Autorii studiului subliniază prudenţa. Ei descriu rezultatele modelului ca o sursă suplimentară de informaţie — nu drept o dovadă definitivă a caracterului sau viitorului unei persoane. Domeniul analizei faciale pentru trăsături comportamentale este încă tânăr, iar acurateţea variază între populaţii şi contexte. Greşelile pot amplifica inechităţile sociale dacă angajatorii, băncile sau proprietarii tratează inferenţele algoritmice ca fiind decisive.

Recomandările practice din studiu includ limitarea utilizării predicţiilor faciale la scenarii în care există transparenţă completă, consimţământ informat şi mecanisme de contestare. În lipsa acestor garanţii, utilizarea ca instrument de selecţie automatizată ar trebui evitată sau strict reglementată.

Possible benefits, real risks and unintended consequences

Sustinătorii tehnologiei susţin că ar putea exista scenarii legitime unde analiza facială oferă valoare: de exemplu, acordarea de microcredite în lipsa unor istorii financiare, evaluări preliminare în situaţii cu volum mare de aplicaţii sau screening de siguranţă în medii specifice. În astfel de cazuri, un algoritm ar putea completa datele tradiţionale, dacă este folosit cu prudenţă şi supraveghere umană.

Cu toate acestea, lucrarea avertizează asupra efectelor comportamentale pe termen lung: utilizarea pe scară largă a instrumentelor de analiză facială ar putea determina oamenii să‑şi modifice aparenţa — fie digital prin filtre şi editări, fie fizic prin intervenţii estetice — pentru a „trişa” sistemele automate. Aceasta ar crea presiuni sociale noi şi ar transforma interacţiunile cotidiene într‑un joc de conformitate cu metrici automate, subminând autenticitatea şi autonomia individuală.

Există şi provocări tehnice şi juridice importante. Instrumentele de recunoaştere facială şi de inferenţă a trăsăturilor intră în coliziune cu legile privind protecţia datelor (de exemplu, GDPR în Europa), reglementările anti‑discriminare şi normele emergente privind sistemele automate de luare a deciziilor. Fără transparenţă robustă, audituri independente şi garanţii de echitate, implementarea la scară largă poate produce prejudicii semnificative.

Mai mult, costurile sociale nu se limitează la discriminare economică: există riscuri pentru sănătatea mintală, demnitate şi viaţa privată. Utilizarea predicţiilor despre personalitate ar putea determina stigmatizare a anumitor trăsături, reducând oportunităţile unor indivizi pe baza unor asocieri statisticale problematice.

Din perspectivă organizatorică, firmele care adoptă astfel de tehnologii riscă litigii, pierderea încrederii publice şi sancţiuni regulatorii dacă nu implementează măsuri de guvernanţă a AI: evaluări de impact, audituri de bias, documentaţie tehnică (model cards) şi canale pentru contestarea deciziilor automate.

What to watch next

Cercetătorii continuă să testeze dacă semnalele inferate facial păstrează valoare predictivă în pieţe de muncă diferite şi în grupuri demografice variate. Reproducerea independentă a rezultatelor, disponibilitatea seturilor de date deschise şi dezbaterea publică de politici vor fi esenţiale pentru a determina utilizările legitime — dacă există — ale inferenţei de personalitate prin AI în recrutare sau în underwriting‑ul de credit.

Important este să urmărim următoarele evoluţii concrete: publicarea de replicări independente, adoptarea standardelor interne de validare (de ex. testare pe subgrupuri demografice), iniţiative legislative privind transparenţa algoritmică şi deciziile cu impact semnificativ asupra vieţii oamenilor, plus dezvoltarea unor instrumente de audit automatizat şi explicaţii interpretabile (explainable AI) aplicabile acestor modele.

Pe termen scurt, companiile, factorii de decizie şi organizaţiile civice trebuie să evalueze utilitatea potenţială în raport cu riscurile la adresa echităţii, confidenţialităţii şi autonomiei individuale. Multe recomandări din literatura de specialitate sugerează abordări prudente: restricţii de aplicare, supraveghere umană obligatorie, notificări clare pentru persoanele evaluate şi verificări externe independente.

Pentru moment, studiul aminteşte că machine learning poate identifica tipare pe care oamenii nu le observă imediat — dar pattern ≠ proof (un tipar nu este echivalentul unei dovezi). Factorii de decizie politici, angajatorii şi specialiştii în tehnologie trebuie să cântărească potenţiala utilitate în raport cu riscurile la adresa echităţii, confidenţialităţii şi autonomiei individuale.

Pe scurt, următoarele acţiuni sunt recomandate pentru actorii relevanţi: realizarea de audituri etice şi tehnice înainte de implementare, consultarea părţilor interesate (angajaţi, organizaţii de protecţie a datelor, societate civilă), testarea modelelor pe date reprezentative şi crearea unor politici care să permită contestarea deciziilor automate. Doar astfel se pot identifica utilizările legitime şi acceptabile din punct de vedere social ale analizei faciale în contexte sensibile precum recrutarea şi creditarea.

În concluzie, subiectul rămâne unul complex şi multidisciplinar: combină psihometrie, viziune computerizată, etică aplicată şi drept. Evoluţiile viitoare vor necesita colaborare între ingineri, psihologi, jurişti şi factori politici pentru a construi cadre care să maximizeze beneficiile potenţiale şi să minimizeze riscurile pentru persoane şi societate.

Sursa: smarti

Lasă un Comentariu